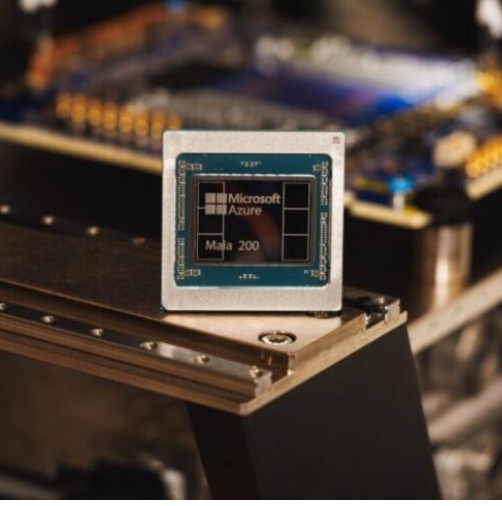

Nueva York. — Microsoft presentó el Maia 200, la segunda generación de su chip de inteligencia artificial (IA), diseñado para reducir la dependencia de Nvidia y competir directamente con los desarrollos de Google y Amazon en el mercado de la nube.

Este nuevo procesador, enfocado en tareas de inferencia, promete hasta un 30 % más de rendimiento por dólar en comparación con el hardware actual de la compañía. Según Scott Guthrie, vicepresidente ejecutivo de Microsoft para la nube y la IA, se trata del “sistema de inferencia más eficiente que Microsoft ha desplegado jamás”.

El Maia 200 ya se está implementando en centros de datos de Azure en Estados Unidos, impulsando servicios como Microsoft 365 Copilot, Foundry y los últimos modelos GPT de OpenAI. Posteriormente, se expandirá a otras regiones.

Los chips utilizan el proceso de tres nanómetros de Taiwan Semiconductor Manufacturing Co. (TSMC), y su lanzamiento se enmarca en la intensa competencia por liderar la IA generativa, donde los grandes proveedores de nube buscan desarrollar microcircuitos propios para no depender exclusivamente de Nvidia.